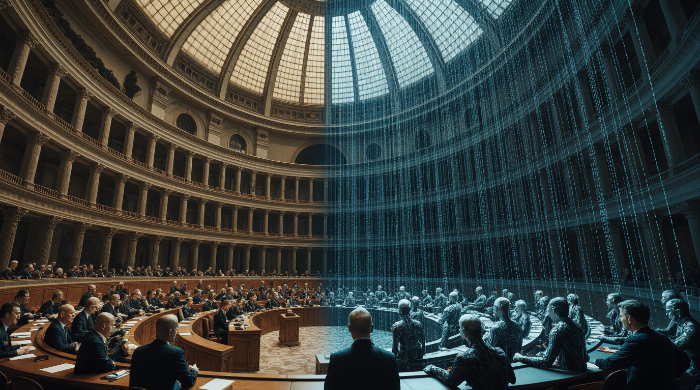

인공지능과 민주주의 는 추천·랭킹 알고리즘이 여론을 재편하는 시대의 핵심 쟁점입니다. 정치 알고리즘의 중립 신화, 설명가능성과 거버넌스 원칙을 짚습니다. 기술은 결정을 내릴 수 있지만, 책임을 질 수는 없습니다.

알고리즘이 여는 정치의 무대

추천 시스템과 검색 랭킹은 우리가 무엇을 보게 될지를 결정하고, 그 선택은 곧 무엇을 믿게 될지에 영향을 줍니다. 토론장의 힘은 플랫폼 설계로 이동했고, 민주주의의 핵심 질문은 이렇게 바뀌었습니다. “판단의 주체는 여전히 인간인가?” 오늘의 자유는 말할 자유뿐 아니라 집중할 자유(freedom of attention)에 달려 있습니다.

정치 알고리즘의 중립 신화

데이터·가중치·목표함수의 정치성

AI 시스템은 결코 중립적이지 않습니다. 뉴스 추천, 검색 순위, 감성 분석 모델에는 설계자의 전제가 스며 있습니다. 과거 데이터에 맞춰 학습된 모델은 평균을 강화하며 소수 의견을 통계적 잡음으로 밀어낼 수 있습니다.

캠페인 자동화와 조작적 설득

심리 프로파일링을 활용한 맞춤 메시지는 설득을 넘어 정서적 조종으로 변질될 위험이 있습니다. 케임브리지 애널리티카 사건은 데이터가 정보가 아니라 곧 권력임을 보여주었습니다.

판단과 합의의 철학(설명가능성과 참여)

칸트의 판단, 인간의 책임

AI는 상관관계를 계산하지만, 의미 부여와 책임은 인간의 영역입니다. 칸트가 말한 판단은 경험을 넘어 보편에 개별을 포섭하는 능력이며, 이 지점에서 양심이 요청됩니다.

하버마스의 대화 구조

정당성은 결과가 아니라 의사소통적 합리성에서 나옵니다. 공적 의사결정에 투입되는 AI는 설명가능성(Explainability)과 참여 거버넌스(Governance)를 통해 검증되어야 하며, 자동화가 아니라 정치적 숙의의 증진이 목표가 되어야 합니다.

‘클릭이 진리’가 되는 사회에 대하여

니체가 말한 “우리가 잊어버린 환상으로서의 진리”는, 오늘날 좋아요와 공유 수로 대체되기 쉽습니다. 다수의 클릭이 진리가 되는 순간, 민주주의는 알고리즘의 과잉 대표에 노출됩니다.

인간이 남겨야 할 마지막 자리

AI는 판단을 돕는 보조자여야 하며, 주체가 되어서는 안 됩니다. 정책과 윤리의 결정권은 데이터가 아니라 인간의 합의 위에 있습니다. 해법은 배제가 아니라 투명성·설명가능성·참여 통제로 AI를 민주적 절차 안에 두는 일입니다. 기술은 결정을 내릴 수 있지만, 결과의 책임을 질 수는 없습니다.